C16~C17

SEED共读共在读书会206期《贝叶斯的博弈》C16~C17

领读:@Yuan

日期:2025-11-30 21:00~23:00

录制文件:https://meeting.tencent.com/crm/KDXbmddD9b

访问密码:0OVR

-

C16 记忆缺陷

-

数据 & 数据处理

- 纸质文件 & 繁琐的书面流程

- 我在搬到瑞士的时候尤其切身感受到了这一点。寻找住处、建立租赁档案,以及房东和租客签订合同,都需要极为烦琐的书面流程

- 数据

- 数据泛滥

- 产出的数据量正在超越我们的

- 分析能力

- 储存能力

- 给计算时间出了难题

- 厕所问题

- 秘书问题、古戈尔游戏、未婚妻问题、苏丹聘金问题……

- 想象一下,你现在身处节日庆典,却有些内急。面前有300个厕所排成一条长街,但这些厕所都脏得可怕,你尝试找到其中最干净的那个。但你身后还跟着一排队伍,一旦你关上一个厕所的门去看下一个厕所,就不能回到之前的厕所了,因为有人已经捷足先登。换句话说,你必须在看到某个厕所的时候就决定是否进去。怎么样才能使你用上最干净的厕所的可能性最大化?

- 最优策略:37%定律

- 先查看大概37%的厕所后全部放弃,然后选择第一个比前面都更干净的厕所。不管厕所有多少个,都能保证以37%的概率找到最干净的厕所

- 话虽如此,我很不建议在实践中采用这一策略。这一策略能将找到最干净的厕所的概率最大化,但并没有指出它失败的后果。其实,通常你放弃了所有厕所,不得不接受最后那一个。这种灾难性的情况出现的概率甚至有37%!

- 信息洪流的高速处理

- 实时优化

- 实时学习

- 这些问题考察的不是作为不确定性的偏见,而是偏见本身的不确定性

- 探索就是优先进行可能代价高昂的测试,以此收集数据来改进贝叶斯置信度;利用则是在给定置信度的情况下进行最优决策。

- 计算时间限制

- 贪心算法

- 人们证明了这种短视可以保证贪心算法是最好的启发式算法,尤其是在与随机化结合之后

- 产出的数据量正在超越我们的

- 卡尔曼滤波器

- 未来≠过去,要处理动态变化,需要预期与计算变化的存在

- 遵循某种高斯分布,其论据主要是中心极限定理

- 后验高斯分布

- 应用:

- 隐马尔可夫模型

- 卡尔曼滤波器是隐马尔可夫模型的特例

- 由隐藏的内部状态产生的外部演变过程。在每一个时刻,内部状态都会产生外部可观察的数据。

- 隐含变量

- 给定前一个时刻隐含变量的可能取值,以及当前时刻仪器测量到的数据,贝叶斯公式就能让我们计算隐含变量在每个时刻的可能取值。

- 这些模型能够实时对海量数据做出反应,无须额外的储存空间,因为需要保存的只有隐含变量概率分布的描述,但这一描述一般非常简洁,在卡尔曼滤波器所用的高斯分布框架中尤其

- 纸质文件 & 繁琐的书面流程

-

记忆 (数据存储)

- 人类的数据输入与处理

- 人们可能从未察觉,每时每刻充斥我们大脑皮层的数据量大得可怕,每秒我们会收到大约十亿字节(1GB)的数据。

- 我们的视皮层拥有惊人的能力,可以将十亿字节的视觉数据转换为几千字节的有用数据,这种处理在每一秒都在进行,而且只需要消耗极少的能量。在更普遍的意义上,大脑会优先保留数据的“大体概念”,而不是具体细节

- 人类的数据存储(记忆)

- 对于接收到的信息只保留压缩过后的表示,这种能力并非弱点,而正是大脑的强大之处。我们一般都能够回忆起那些重要的事物,而且完全忘却那些对我们来说无足轻重的东西。

- 擦除记忆

- 普萘洛尔,这种药物的分子会插入神经元之间,中断神经元的通信

- 这些工作指出了一个已经确立的反直觉的事实:记忆储存于突触连接之中。

- 当我们在回忆时,大脑皮层中涌现出一波波神经激活。正是这些波涛的纹路刻画了我们的记忆。这些记忆藏身于神经元的连接方式之中,而非神经元自身的物理状态之中。因此,与回忆相关的信息并非聚集在大脑的特定区域之中,而是遍布于组成大脑的神经网络连接之中。

- 虚假回忆

- 实验表明,我们不能相信自己的回忆。我们的回忆并不精确,充满模糊之处,特别是在每一次重新回忆时,它会又一次被调整、加工和改编。

- 非注意盲视

- 我们总是尝试通过理性来为自己的第一直觉辩护,这就意味着我们很乐意调整自己的回忆

- 关于回忆的这些严重问题指出了大脑能力的极限,也提示我们要大大降低对于回忆的置信度,对于建立在这些回忆之上的信念也是如此。

- ∴

- 要如同科学家对待实验数据般对待自己的记忆:永远保持可证伪性的开放心态

- “所有模型都是错的”,所以知识并不在于刻画那些正确性无可争议的事实或者理论,而更应该是对于不同事实、理论和回忆的置信度的计算。知识,旨在确定合适的不确定程度

- 记忆压缩

- 人类大脑令人叹服的地方之一,就是它将极大量原始数据压缩为寥寥几个想法的能力

- 自编码器

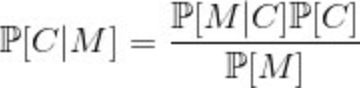

- 对数据重组,其实就是确定什么数据会得出眼前这个摘要。这正是贝叶斯公式的典型应用!我们需要确定这个摘要的可能原因,因此我们有

- 贝叶斯公式也可以用于确定适用于不同记忆的编码。这就让我们能够只保留记忆中的精华,将它们压缩到只需占用极小的储存空间

- 对数据重组,其实就是确定什么数据会得出眼前这个摘要。这正是贝叶斯公式的典型应用!我们需要确定这个摘要的可能原因,因此我们有

- 克劳德·香农也说他在学校里学到的化学“(对他来说)似乎一直都有点无聊”:“在我看来,孤立的事实太多,一般性的原则太少。”

- 短期记忆 & 长期记忆

- 长期记忆。其中,信息被储存在大脑皮层这一神经网络的拓扑结构之中

- 短期记忆、缓存Cache。

- 长期记忆被铭刻在神经网络的连接方法之中,而短期记忆可能主要由神经递质控制——尽管这个假设未经大量实验证实,因此不值得对它赋予很高的置信度。

- 递归神经网络

- 人工神经网络的研究选择了第三条道路:神经信号的环路传播。

- 在处理当前数据时,这种网络能够利用前一时刻的部分信息。擅于处理本质上有时序特性的数据。

- 内部状态:

- 内部状态的任务就是以精练的方式提取出前一时刻的信息

- 递归神经网络&读书

- 因此,有时候先迅速浏览一遍,再多花点时间细细阅读,最后再速读一遍,这样可能效果更好。每一次阅读都会带来新的东西,因为每一次阅读都联系着短期记忆这一内部状态的不同变化动态。

- 双向递归神经网络

- 为了同时利用过去和未来的数据理解现在

- LSTM架构,意思是“长短期记忆”(long - short -term memory),迫使遗忘的神经元件

- LSTM还拥有另一个额外的环路,它激活的时候会强制让所有神经元环路中的信号消失。

- Transformer架构

- 人类的数据输入与处理

-

教育的启示 (应该学什么、应该教什么)

- 与人类的记忆一样,人工神经网络的记忆在可靠性方面也没有保障,无论它的编码是在神经网络的连接之中还是在网络环路传播的数据之中。

- 我们身边的计算机至少在两项计算任务上远远超越了我们:计算速度以及信息的可靠储存。

- 新技术可能已经改变了你的大脑皮层。我们沉迷于智能手机、谷歌和维基百科,这似乎影响了我们对记忆的管理。这不一定是坏事。

- 将过去的记忆容量用于理解更深刻的东西

- 知道怎么查找信息应该优于单纯把信息记住。

- 我个人认为,在学校要学习的知识和技能都太多了。不仅如此,这些知识通常是作为绝对真理来传授的,技能则被当成非此不可的解答方法。然而,无论是纯粹贝叶斯主义者还是实用贝叶斯主义者,对他们来说,“所有模型都是错的”。但依我看来,这还不是问题最大的地方。

- 知识和技能的过剩损害了对概念和模型的理解,尤其是对理解这个世界来说最有用、最可信的概念和模型。这种教育往往忽略了模型可信的原因及其适用范围。我的意见是,教授的内容应该大量减少,教师应该只教授那些违反直觉并且有教育意义的重要内容。比如说,我认为应该教授认知偏差、演化理论的关键过程、理论计算机科学和道德功利主义,同时可以削减三角学和量子力学等内容。

- 此外,贝叶斯公式似乎提示我们应该通过例子来学习,而不是直接记住理论——我们会在接下来的章节中看到,我们的大脑似乎偏向贝叶斯主义,从具体事例出发很快就能推广到一般情况。因此,似乎只有在获得了足够的数据,并使这些数据可以“轻松访问”,让我们能够轻易估计贝叶斯公式中的思想实验项之后,理论的重要性才会突然显现。这样的话,似乎在考虑大量例子,使理论的效用凸显眼前之后,再去学习这些理论才更合适。比如说,我们应该先以游戏、谜题和逻辑悖论等能吸引学生的形式来引入数学,之后再向他们解释这些内容都是更普遍的理论的应用事例——这正是我在这本书中努力尝试的做法。

- 但依我愚见,要教授的最重要的内容还是认识论,还有对于认识论的应用来说不可或缺的统计学。

- 我认为是时候放弃积累公认正确的教条知识这种做法了,应当转而教授知识是什么、如何获得知识、如何分辨可信的理论和不值得赋予置信度的理论。

-

-

C17 睡梦是你的顾问

-

想法从何而来 (灵感的涌现)

- [[Poincare庞加莱]]: “思想就是漫漫长夜之中的一道闪电,但这道闪电就是一切

- 数学家这种让潜意识不断工作的能力正是他们能轻松处理熟悉的数学对象的主要原因

- 系统三

- [[丹尼尔·卡内曼]] [[BOOK/思考,快与慢]]

- 系统一: 快系统、直觉

- 系统二: 慢系统、理性

- 睡梦时潜意识里都对某件事物紧抓不放 → 系统三,它会指导系统一,但系统二却不会觉察到这件事

- 系统三:一种经过高强度训练后的、能在潜意识里自动解决复杂逻辑问题的能力。

- 弗朗西斯·克里克(DNA双螺旋发现人)偕同格雷姆·米奇森的假设

- 做梦是为了遗忘

- 你今天看见一只红色的鸟,然后正好摔了一跤。你的大脑可能会建立一个奇怪的连接:“红色的鸟 = 摔跤”。

- 如果我们的大脑只管“记”,不管“忘”,会发生什么? 这些神经连接会变得越来越乱,充满了各种垃圾信息和错误的关联(比如以后一看见红鸟你就腿软)。科学家管这个叫“寄生模式”(Parasitic Modes)或者“死循环”。如果这玩意儿多了,你的脑子就过载了,甚至会产生幻觉,分不清现实和想象。

- 克里克和米奇森的假设就是:做梦(特别是快速眼动睡眠 REM 阶段),其实是大脑的“垃圾清理时间”。在梦里,大脑会故意激活这些乱七八糟的、错误的、没用的连接,然后反向操作——削弱它们,切断它们简单说:我们做梦,是为了遗忘(We dream to forget)。 只有忘掉那些没用的噪音,你醒来后才能更聪明、更清楚地思考。

- 大脑的困境:过拟合现实,把噪声当成信号(强加因果) → 所以要默省最优化,需要去除噪音

- 做梦是为了遗忘

- 运行机制

- 输入:极度的痴迷(这是前提!)、显意识输入

- 处理: 潜意识后台运行、利用系统一的能力处理系统二的信息

- 输出: 灵感,系统三的处理结果

- 弗朗西斯·克里克(DNA双螺旋发现人)偕同格雷姆·米奇森的假设

- [[丹尼尔·卡内曼]] [[BOOK/思考,快与慢]]

-

生成模型 & 机器创造 (概念→数据) 创造力是贝叶斯采样的结果

- 贝叶斯创造力公式: $$P(\text{数据} | \text{抽象概念})$$

- 即给定被激活的抽象概念时数据出现的概率,进行抽样。这样的话,根据贝叶斯主义,创造性可以归结为根据带有语境的置信度进行抽样。

- 创造有迹可循:遵循概念约束的概率规律新颖可控平衡:通过温度参数调节人机协同可能:Al扩展人类的抽样能力。最终,创造力或许既非神赐灵感,也非随机变异,而是在知识先验与概念似然共同约束下的最优采样

- 如同在繁星中绘制星座,既受星辰位置限制,又蕴含无限可能。

- 机器艺术

- 虽然神经网络通常从数据推断出能够概括这些数据的抽象概念,但我们可以要求这些神经网络在已知抽象概念的情况下猜测可能与之有关的数据。然后,选择那些一般而言没有联系的抽象概念,我们就能让神经网络创造出一些既不常见但又相对可信的数据。这就是机器的艺术生成过程

- 即给定被激活的抽象概念时数据出现的概率,进行抽样。这样的话,根据贝叶斯主义,创造性可以归结为根据带有语境的置信度进行抽样。

- 计算机科学家艾伦·凯(Alan Kay):"预测未来的最好方式是发明它。"

- 在贝叶斯主义者看来,未来不是一条固定的路,而是一个概率分布。我们要做的,就是从这个分布里,采样出我们最想要的那一种未来,并把它变成现实。

- 温度(Temperature)的作用:

- 这其实是借用了物理学的概念。

- 低温创造: 机器会很保守,只画最像猫的猫,虽然准确但无聊。

- 高温创造: 机器会很疯狂,画出长翅膀的猫,甚至变成一团乱麻。

- 真正的艺术: 就在于调节这个“温度”,找到新颖与可信之间的平衡点。

- 人类的自然学习方式也似乎更倾向于依赖那些有代表性的例子,而不是形式化的理论,因为我们的大脑也是一个贝叶斯机器,更容易从具体的例子(Data)中,去反向推断出背后的道理(Abstract Concept)

- 案例、故事、比喻、类比……

- 贝叶斯创造力公式: $$P(\text{数据} | \text{抽象概念})$$

-

隐含狄利克雷分布LDA(latent Dirichletallocation)-(数据→概念)

- 是什么:

- LDA是贝叶斯网络的典型例子。它拥有因果性的结构,目的是从观察数据中推断出抽象概念。

- 文档中的所有单词都可以通过以下的因果性过程得到

- 说人话:负责把混乱的信息归类,比如给文章找主题,假定每篇文章都有一些特定的主题(都可以被归类),通过分析聚类词语出现的频率,反向推导文章的可能主题

- 层次LDA

- 说人话:一级分类下面还有二级分类。心理学还要分社会心理学、进化心理学……文学还要分诗歌、散文、小说……

- 聚类:

- 中餐馆过程(Chinese restaurant process)

- 想象一家无限大的中餐馆。

- 第一个顾客进来,坐第一张桌子。

- 第二个顾客进来,他可以坐第一张桌子(和第一个人挤挤),也可以开一张新桌子。

- 关键来了:如果某张桌子坐的人越多,新来的顾客就越可能去坐那张桌子。 人们喜欢凑热闹!

- 想象一家无限大的中餐馆。

- 桌子是主题、顾客是数据。数据会自动聚集到那些已经很热门的分类里,偶尔也会创造新分类。这就是为什么它是非参数化的——我们不用提前规定有多少张桌子(多少个分类),让数据自己决定。

- $$K \approx 1 + \frac{1}{2} + \frac{1}{3} + \frac{1}{4} + ... + \frac{1}{N}$$

- 人们可以证类别个数是数据数量的对数

- 随着你见识(数据 N)的增长,这世界上能让你感到“新鲜”并需要“新建分类”的事情,是变得越来越稀缺的。

- 从数学上讲,是因为那个 $1/N$ 越来越小。

- 从生活上讲,是因为打破常规越来越难。

- 人们可以证类别个数是数据数量的对数

- 中餐馆过程(Chinese restaurant process)

- 是什么:

-

蒙特卡罗模拟

- 是什么: 通过大量的随机试验,来逼近一个准确的答案

- 布丰投针实验

- 拿一盒缝衣针和一大张纸,在纸上以缝衣针长度的4倍为间隔画上平行线,然后在纸上投掷大量的缝衣针。现在计算与平行线相交的缝衣针比例有多少,这个比例大概就是几何中的基本常数[插图]的倒数,而[插图]就是圆的周长与半径之比

- 这些模拟在研究系统关于初始状态变化的敏感度时尤其有用。

- 拿一盒缝衣针和一大张纸,在纸上以缝衣针长度的4倍为间隔画上平行线,然后在纸上投掷大量的缝衣针。现在计算与平行线相交的缝衣针比例有多少,这个比例大概就是几何中的基本常数[插图]的倒数,而[插图]就是圆的周长与半径之比

-

随机梯度下降法SGD (stochastic gradient descent)

- 随机迈出一步先走走看

- 与其尝试让理论符合整个数据集,SGD会从中随机抽出几项数据,然后向这几个数据的解释迈出一步。用神经网络的术语来说,这相当于稍微调整突触连接,使得神经网络的计算能更好地贴合刚才随机选取的数据。然后SGD会多次重复这一步骤,直到它对随机抽样数据的解释足够正确。

- 2017年,曼特、霍夫曼和布莱成功将SGD重新诠释为一种近似贝叶斯推断,其中SGD的每一次随机数据抽选都会让模型的参数出现浮动。通过调整与这种浮动相关的参数,这三位研究者甚至能够证明这些浮动能让算法适当地探索一组可信的模型,而不是只限制于MAP模型(最可信的模型)

- 普通的算法只想找到一个最好的答案(MAP,最大后验概率)。就像一定要找到那个唯一的山谷最低点。 但 SGD 因为像个醉汉一样晃晃悠悠(“浮动”),它不会死死卡在一个小坑里不动。它会在山谷底部周围乱逛。 这很有用! 因为这一系列的“乱逛”,其实描绘出了整个山谷底部的形状(后验分布)。它不仅告诉了你答案在哪里,还告诉了你这个答案有多“宽”、多“可信”。这就是贝叶斯想做的事——不仅要结果,还要知道不确定性

- 与我们在第12章中提到的随机失活方法一样,SGD的这种随机特性,尤其是它不会收敛于MAP(最大后验概率)模型这一点,可能会让它成为对贝叶斯公式进行更好的模拟时必须考虑的方法

- MAP是最完美的最低点,但存在过度拟合的问题

- 世界是不确定的。如果你只给我一个点(MAP),你丢掉了太多信息

- 但从技术角度来说,SGD的抽样确实非常简单,只需在已知列表中随机选取数据即可。但在更复杂的情况中,抽样本身可能就是需要研究的领域

- 上课点名 v.s. 算命猜人名

- 随机迈出一步先走走看

-

伪随机数

- 真正的随机性并非必要。这些数字只需要拥有“足够随机”的性质就可以了

-

重要性抽样(importance sampling)

- 要根据目标分布进行抽样的话, 就要先根据参考分布进行抽样,然后我们对抽样点赋予一个重要度,与这个点在目标分布中被抽选到的概率成正比。

- 在不知道某个随机变量的具体分布,但能够计算该变量的两个取值的概率比值的情况下,重要性抽样就尤其有用

-

重要性抽样能助LDA一臂之力

- 边缘分布或者配分函数

- 我们可以计算两个不同类别概率的比值,无须知道分母是多少

- 推荐系统

- 给定你的Facebook、iTunes或者亚马逊的历史数据,向你推荐什么样的文章、音乐或者产品才最合适

- 边缘分布或者配分函数

-

伊辛模型

- [[相变]]

- 伦茨和伊辛提出的问题就是,在给定的温度下,这些自旋是否会倾向于保持同一方向(^^随大流^^)。换句话说,在温度下,自旋大体统一排列的位形是否比自旋没有统一排列的位形更可能出现?

- 玻尔兹曼发现,在温度为的热力学平衡态中,能量为[的位形[插图]出现的概率正比于[插图],其中[插图]就是所谓的玻尔兹曼常数。更精确地说,玻尔兹曼分布表明,位形[插图]出现的概率是[插图]这个方程的分母就是有名的配分函数

- 关键在于,温度[插图]越低,这个现象越显著。

- 在温度较低时,拥有高能量的位形,也就是那些自旋没有对齐的位形,出现频率呈指数下降的速度很快,因此,更可信的位形就是那些自旋方向较为统一的位形,这就让铁带有了磁性。反过来说,在温度较高时,如果我们假设[插图]远远小于[插图],那么[插图]这个量就非常接近1。然而,自旋没有对齐的位形个数是自旋对齐的指数倍,因为如果你(独立均匀地)随机选取自旋的取值,那么它们几乎不可能大体选取同一方向。这样的话,在高温时,自旋没有对齐的位形集合出现的可能性是自旋对齐的位形集合的指数倍,因此铁的磁性会消失。

- 伊辛模型是马尔可夫随机场的绝妙范例

-

玻尔兹曼机

- 马尔可夫随机场可以被描述为众多以无向边相连的随机变量,因此它与贝叶斯网络极为相似

- 马尔可夫随机场中的边并不代表因果关系,而是代表变量之间的某种相关性,与之相对的就是那些没有被连起来的变量,它们从直觉上来说几乎是相互独立的

- 受限玻尔兹曼机(restricted Boltzmann machine)

- 受限玻尔兹曼机就是一个马尔可夫场,其中每条边都将一个可观测变量与一个隐藏变量连接起来

- 换句话说,这是一个二部图,一半是可观测变量,另一半是隐藏变量。

- 受限玻尔兹曼机就是一个马尔可夫场,其中每条边都将一个可观测变量与一个隐藏变量连接起来

- 玻尔兹曼机会向每条边赋予一个衡量相关性的能量

- 玻尔兹曼机通过隐藏变量将可观测变量连接起来。当其中一些可观测变量被观测时(这里以黑色表示),我们就能利用所有可观测变量通过隐藏变量达成的隐藏联系来猜测未被观测的可观测变量的可能值

-

MCMC(马尔可夫链蒙特卡罗)

- 是什么:在可能性组成的集合中随机游走

- 随机游走中的每一步对于目标分布来说绝对不具有代表性。

- 谷歌的PageRank

- 强连通

- 梅特罗波利斯-黑廷斯抽样

- 令当前状态为[插图],假设随机的下一步会将我们引向状态[插图]。为了决定应该接受还是拒绝这一步,梅特罗波利斯–黑廷斯抽样告诉我们应该先计算接受率[插图]

- 状态[插图]比状态[插图]更可能发生,而且从[插图]到[插图]这一步很可能可逆,即反过来的那一步(也就是从[插图]到[插图])在随机漫步中被选择的概率与原来相比不算太小的话,那么从[插图]到[插图]这一步的接受率就会取较大的值。

- 更进一步,我们可以在抽样中加入可观测变量的观测值的条件,只需在漫步时禁止改变这些变量的值即可。

- 将这些概率替换为对状态[插图]和[插图]的效果度量[插图]和[插图]

- 吉布斯抽样(Gibbs sampling)

- 如果给定可观测变量的值,那么受限玻尔兹曼机的总能量就是隐藏变量的一个线性函数

- 给定已观测的变量,每一个隐藏变量都可以进行独立抽样

- 在给定某些可观测变量的实际观测值的条件下,对未被观测的可观测变量的可能取值的具有代表性的抽样结果

- 抽样得到的数据就会在很大程度上取决于随机漫步的起点,而在我们希望抽样的分布中,这些起点完全不具备代表性。

- 在庞大的数据集合中,只有一小部分数据的置信度是不可忽略的。可信理论的集合一般来说也是如此,它们在充满荒诞理论的极高维海洋中组成了寥寥几个小岛

- 如果未曾探索过任何真正可靠的数据的话,那么所有已探索过的数据都会看起来很可靠!

-

MCMC与认知偏差(偏见)

- 可得性偏差(availability bias):通常会赋予脑海中出现的第一个想法过高的重要性。

- 这一偏差似乎揭示了我们的大脑也用到了MCMC。如果没有经过足够长时间的思考,那么MCMC就会严重地受到起点的影响

- 它在思想世界中随机漫步的出发点……在不知情的状态下,我们的思考被身处的场景高度影响,其程度令人难以置信。这就是启动效应(priming effect)。

- 锚定效应(anchoring effect)

- 损失厌恶(loss aversion)。

- 这个理论的基础就是我们的偏好总是强烈受参照物影响的事实。相对于这一参照物而言的收益是好事,但相对的损失却令人有灾难的感觉

- MCMC的有效性只有在经过大量随机转移步骤之后才会凸显出来

- 我们也绝对必须花时间——比现实中一般情况更长的时间——去思考……长时间冥想和睡眠的好处,有一部分可能就在于能够延长MCMC的计算

- 可得性偏差(availability bias):通常会赋予脑海中出现的第一个想法过高的重要性。

- 是什么:在可能性组成的集合中随机游走

- [[Poincare庞加莱]]: “思想就是漫漫长夜之中的一道闪电,但这道闪电就是一切

-

梦的作用

-

对比散度算法(contrastive divergence) &

- 梦的作用尤其集中在另一个用于机器学习的算法。这个算法的目标是,给定某个带有隐藏变量的模型,计算其MAP参数

- 这简直太美妙了。 我们在训练机器时,有一个阶段叫“正向”(醒着):看到数据,调整连线。还有一个阶段叫“反向”(做梦):把输入关掉,让网络自己瞎想,产生幻觉。做梦(对比散度)的作用是: 看看我的大脑在瞎想时会造出什么垃圾(比如长翅膀的猪)。如果造出来了,我就惩罚那些导致这个幻觉的连接,把它们调弱。做梦是为了遗忘谬误,为了让大脑的模型更真实。

- 梦的作用尤其集中在另一个用于机器学习的算法。这个算法的目标是,给定某个带有隐藏变量的模型,计算其MAP参数

- [[IIT整合信息理论]] by 吉列尔莫·托诺尼(GiulioTononi)

- “意识”就是信息的高度整合。梦不是噪音,而是大脑的对比散度算法。梦是系统在自我清理、自我整合。通过消解无关连接,提炼本质信息。

- [[John von Neumann冯诺依曼]]:"生命与机器的边界在于,生命能用不精确实现更高层次的精确。"

- 梦或许正是这种生物智慧的终极体现:在看似混乱的夜间漫游中,完成最精密的参数调谐。

- 哈默斯利–克利福德定理(Hammersley -Clifford Theorem)证明了马尔可夫性质等价于要求概率密度可以分解为团(clique)上函数的乘积,也就是[插图],其中[插图]是由所有[插图]组成的向量,其中[插图]。

- 证明了“局部的邻居关系”(马尔可夫场,我和我朋友的关系)等价于“全局的能量分布”(吉布斯分布,物理学的能量公式)。 这就允许我们用物理学的数学工具(能量、温度),来解决计算机的图像识别或逻辑推理问题。

-

-

IN SUM

- 世界很乱,我们用LDA来分类。

- 世界太复杂算不准,我们用蒙特卡罗去扔针、去猜。

- 我们像醉汉一样(SGD、MCMC)在山谷里跌跌撞撞寻找真理。

- 我们的大脑(玻尔兹曼机)就像一堆磁铁,在寻找最舒适的能量状态。

- 白天我们学习,晚上我们做梦(对比散度),就是为了把白天学到的正确连接留下,用系统三处理想不明白的地方,再把那些错误的连接给擦掉。

- 这就是贝叶斯的博弈:用随机性来对抗未知,用不断的试错来逼近真理。

-