C18

- SEED读书会

- 引入:

-

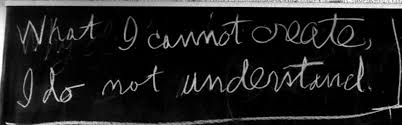

What I cannot create, I do not understand. 如果我不能创造它,我就没有理解它。—— 费曼 Richard Feynman

-

-

C18 抽象方法超出常理的有效性

(先创造、再理解)

-

深度学习

- 经典软件工程方法 - 特征工程

- 先构筑一个理论,用来保证某项技术能正确运作;然后,人们就会沮丧地发现技术超出了理论

- 手动定义特征、规则(教给机器全部知识)

-

深度学习

- 深度学习就是研究那些包含多层隐藏变量的模型,例如LDA和某些玻尔兹曼机。其使用了深度隐藏的变量,经由大量中间变量,将可观测变量传递到深度变量

- 特征学习:通过层级逐步抽象自动提取特征(数据预处理自动化)

- 像大脑皮层处理视觉

- 第一层:感知亮度和颜色

- 第二层:衡量相邻像素间的相关度(像素级)

- 第三层:将相关度结合起来,找出线条(线条级)

- 第四层:线条结合起来,形成基本对象,识别眼睛、耳朵(部件级)

- 之后的深层:组合基本对象,识别“绵羊”(概念级)

- 隐藏神经元对数据的处理可以被看作对某个能解释已观测变量之间相关性的重要抽象概念的计算

- 像大脑皮层处理视觉

-

CNN卷积神经网络

- 经典软件工程方法 - 特征工程

-

抽象有效性

-

单词的向量表示 - word2vec

- 与其让单一的神经元专门负责每一个词语的理解,不如通过每个词语与其他词语之间的关系来理解它们

- 词语组成的空间嵌入高维线性空间中,这个维度一般来说在50和100之间

-

可视化演示:https://gemini.google.com/share/d256ed61f149

- 阅读的神经网络架构

-

深度网络: 从抽象到表达到涌现

-

Exponential Expressivity in Deep Neural Networks through Transient Chaos

- Method: 平均场理论(Mean Field Theory)

- Conl. 几何结构的复杂度会随着神经网络深度的增加呈指数增加

-

深度网络具有指数级的表达能力

- 神经网络不过是一个复杂的数学函数。这个函数以一组测量数据作为输入,然后将其转化为深度概念的组合。测量数据的集。

- 浅层网络 v.s. 深层网络

- 为什么浅层网络不好使?

- 深层网络怎么做?→ 折叠足够多次

- WHY?

- 把神经网络看作几何变换: 想象你的输入数据(比如猫的照片)分布在一个平滑的纸面(流形)上。神经网络的每一层都在对这张纸进行折叠、拉伸和扭曲。

- 宽度的作用(多项式增长): 如果你把网络变宽(增加神经元数量),你只是在这一层里增加了更多的“折痕”。这种复杂度的增加是线性的或多项式的,效率相对较低。

- 深度的作用(指数增长): 如果你把网络变深,每一层都在上一层的基础上继续折叠。

- 第1层:折1次。

- 第2层:在折过的基础上再折1次(变成2层)。

- 第3层:再折(变成4层)...

- 第100层:复杂度是 $2^{100}$。

- 论文证明,在混沌状态下,输入流形的平均外曲率(Mean Extrinsic Curvature)随深度指数级增长。这意味着原本平滑的几何形状,经过深层网络的处理,会被揉成一个极其复杂、充满褶皱的形状。

- 分形

- 就是无限的细节和自相似性,无论放大多少倍都能看到复杂的结构。

-

复杂性的表达: 混沌与秩序的边缘 (The Edge of Chaos)

- 什么是足够“激动”?

- 有序状态,Ordered Phase

- 没有多少变化,信号传导“梯度消失”

- 混沌状态,Chaotic Phase

- 变化太剧烈,微小的输入导致输出的剧烈变化,无法正常传导信号

- ∴ 最完美的网络,必须处于一种“瞬态混沌”(Transient Chaos)的状态

- 大脑的临界态: [[BOOK/The Cortex and the Critical Point]]

- 有序状态,Ordered Phase

- 什么是足够“激动”?

-

深度 > 宽度

- 这篇论文证明了,对于足够“激动”的随机神经网络,几何图形的曲率会随着网络宽度的增长而呈多项式函数上升,并随着深度的增长呈指数上升。换句话说,比起宽度,网络的深度能让神经网络以更快的速度使对应的几何变换变得更复杂。这说明,深度是识别与分析分形结构的关键,分形结构代表的就是那些并不总是光滑且正则的行为

- 一个深层网络可以用比较少的神经元,把空间折叠得非常复杂(这叫曲率增长),从而把极其复杂的数据区分开。而一个浅层网络要想做到同样的效果,需要的神经元数量是天文数字,根本造不出来。

- 这篇论文证明了,对于足够“激动”的随机神经网络,几何图形的曲率会随着网络宽度的增长而呈多项式函数上升,并随着深度的增长呈指数上升。换句话说,比起宽度,网络的深度能让神经网络以更快的速度使对应的几何变换变得更复杂。这说明,深度是识别与分析分形结构的关键,分形结构代表的就是那些并不总是光滑且正则的行为

-

NOW:

- Neural Tangent Kernel (NTK)

- 当网络宽度变得无限大时,超级宽的网络其实就像一个线性模型(高斯过程)。

- ResNet 残差网络

- 通过“跳跃连接”(Skip Connections)强行让信号通过,某种程度上绕过了这篇论文担心的“混沌/有序”崩塌问题,让网络可以深到几千层。解决梯度消失。

- 普通神经网络:输入 x → [层] → 输出 y。

- ResNet:输入 x → [层] → 变化量F(x)。 最终输出=F(x)+x。

- 不论中间层怎样变,原信号直接穿透不改变。

- Transformer

- 让信息的传递不再仅仅依赖层的深度,而是依赖内容本身。这篇论文里的“混沌边缘”理论在Transformer里变得更复杂了,因为那里的非线性不仅仅是逐点的激活函数,而是矩阵乘法

-

可视化演示:https://gemini.google.com/share/7ffec0d83809

- 从表达到涌现

- 当模型大到一定程度(参数量巨大),它突然学会了原本不会的技能(比如推理)。这是平均场理论没有预测到的。

- Neural Tangent Kernel (NTK)

-

Quantifying the Rise and Fall of Complexity in Closed Systems: The Coffee Automaton

- 探讨了一个物理学和信息论中的核心直觉:虽然热力学第二定律告诉我们**熵(Entropy)总是单调增加的,但系统的复杂性(Complexity)**或“有趣程度”通常表现为先上升、后下降的趋势 。

-

1. 核心问题:熵 vs. 复杂性

- 论文首先指出了一个直觉上的矛盾:

- 熵(Entropy):衡量系统的无序程度。在一个封闭系统(如一杯刚倒入奶油的咖啡,或者整个宇宙)中,熵从低到高,最终达到热寂(完全混合、均匀、无聊的状态)

- 复杂性(Complexity):衡量系统的“结构”或“有趣程度”。

- 初始状态(奶油和咖啡完全分离):简单,易于描述(上面是奶油,下面是咖啡)。低熵,低复杂性 。

- 最终状态(完全混合的灰色液体):简单,易于描述(均匀混合物)。高熵,低复杂性 。

- 中间状态(复杂的漩涡和卷须结构):难以描述,包含复杂的几何结构。中等熵,高复杂性 。

- 作者的目标是找到一种数学定义和测量方法,能够定量地复现这种“先升后降”的复杂性曲线 。

- 论文首先指出了一个直觉上的矛盾:

-

2. 方法论:如何定义“复杂性”?

- 作者考察了多种衡量标准(如柯尔莫哥洛夫复杂性、复杂度 sophistication、逻辑深度等),最终选择了一种被称为**“表观复杂性”(Apparent Complexity)**的度量方法 。

- 核心思想:真正的复杂性不应包含纯粹的随机噪声(因为随机噪声的熵很高,但并不“复杂”或“有趣”)。

- 实施方案:粗粒化(Coarse-graining):对系统状态进行“模糊化”处理。通过计算局部区域的平均值,去除微观的随机波动(噪声),只保留宏观结构 。压缩(Compression):将粗粒化后的图像数据进行压缩(如使用 gzip)。压缩后的大小被视为“表观复杂性”的近似值 。

- 如果图像是纯色(完全分离或完全混合),压缩后很小(低复杂性)。

- 如果图像包含宏观的结构(漩涡),压缩后较大(高复杂性)。

- 作者考察了多种衡量标准(如柯尔莫哥洛夫复杂性、复杂度 sophistication、逻辑深度等),最终选择了一种被称为**“表观复杂性”(Apparent Complexity)**的度量方法 。

-

3. 实验模型:咖啡自动机

- 作者设计了一个二维细胞自动机来模拟咖啡和奶油的混合 。

- 初始状态:上半部分是奶油(1),下半部分是咖啡(0) 。

- 两种动力学模型:

- 相互作用模型(Interacting Model):模拟真实物质。粒子不能重叠(一个格子只能有一个粒子)。相邻的异色粒子随机交换位置 。

- 非相互作用模型(Non-Interacting Model):模拟“幽灵”粒子。粒子可以重叠,每个粒子独立进行随机游走,互不影响 。

- 作者设计了一个二维细胞自动机来模拟咖啡和奶油的混合 。

-

4. 关键发现

- 实验结果揭示了“相互作用”对于产生复杂性的关键作用:

- 相互作用模型(Interacting):

- 熵:随着时间单调增加 。

- 复杂性:呈现出明显的倒U型曲线(先上升,达到峰值,然后下降)。这完美验证了“咖啡杯”和“宇宙演化”的直觉 。

- 视觉效果:确实产生了类似流体混合的复杂边界和团块结构 。

- 非相互作用模型(Non-Interacting):

- 最初的实验显示其复杂性也增加了,但这后来被证明是测量方法的伪影(Artifacts) 。因为简单的梯度在粗粒化阈值边缘会产生类似噪声的跳变。

- 修正后的结论:当作者引入了更精细的“调整粗粒化”(Adjusted Coarse-Graining)方法消除伪影后,非相互作用模型的复杂性始终保持在很低的水平 。

- 理论解释:非相互作用粒子的分布完全由简单的统计规律(随机游走)决定,只要知道行号就能预测密度,因此它从未真正产生复杂的结构

- 实验结果揭示了“相互作用”对于产生复杂性的关键作用:

-

5. 结论与意义

- 这篇文章的主要贡献在于:

- 量化验证:首次通过数值模拟定量地证实了封闭系统中复杂性“先升后降”的演化规律 。

- 物理洞见:揭示了**“相互作用”(Interaction)**是产生复杂性的必要条件。简单的扩散(非相互作用)只能导致熵增,却无法产生结构复杂性;只有当粒子之间存在相互排斥或碰撞时,才会涌现出复杂的宏观结构 。

- 方法论贡献:提出了一种基于“粗粒化+压缩”的实用方法来测量物理系统的表观复杂性,并指出了直接阈值化可能带来的测量误差 。

- 简而言之,宇宙之所以有趣(有恒星、星系、生命),是因为粒子之间有相互作用,阻止了它们瞬间扩散成均匀的混沌,从而在通往热寂的漫长道路上,维持了很长一段时间的“高复杂性”状态。

- 这篇文章的主要贡献在于:

-

-

复杂性的度量

-

柯尔莫哥洛夫复杂度(Kolmogorov Complexity, K(x))

- 是什么? 它是描述一个对象所需的最短计算机程序的长度 1。

- 通俗理解: 它是“绝对的信息量”。

- 对咖啡杯的问题: 它不管你是有趣还是无聊。完全混合的咖啡(高熵)和充满漩涡的咖啡,如果从微观粒子看,它们的K(x)都很高。

- 缺点: 它分不清“毫无意义的随机噪声”和“精妙的结构”。一堆乱码的K(x) 最大,但那是“复杂”吗?不,那是“乱”

-

柯尔莫哥洛夫精致度(Kolmogorov Sophistication, soph(x)) ≈ 逻辑深度

- 是什么? 它试图把一个对象拆成两部分:“结构”(Structure/Model)+ “噪声”(Noise/Data)3。

- 定义: 精致度就是那个“结构”部分的程序长度。即:如果要用一个两部分的代码来描述对象(先描述规律集 $S$,再描述 $x$ 是 $S$ 里的哪一个),那个规律集 $S$ 的最小长度就是精致度 4。

- 通俗理解: 比如你有一张星空的照片。

- $K(x)$ 会很高,因为你要记录每个星星的坐标。

- 精致度 只描述“这是星空,星星服从泊松分布”。这部分很短。剩下的部分(具体的坐标)被归类为“随机数据”。

- 高精致度: 只有那些包含“无法用简单的随机分布概括的独特结构”的东西(比如生物DNA),精致度才高。

-

本内特的逻辑深度

- 是什么? 它不看程序有多短,而是看最短的程序要跑多久才能输出这个结果

- 通俗理解: 它是“演化的历史”。

- 写一个程序输出“1111...”(简单):代码短,运行快 → 深度浅。

- 写一个程序输出“随机数”(随机):代码就是随机数本身(print "..."),运行极快 → 深度浅。

- 写一个程序模拟“生命进化”(复杂):代码可能很短(物理定律),但要运行几十亿年才能得到现在的人类 → 深度极深。

-

表观复杂性 ≈ 穷人版的精致度

- 是什么? 这是这篇论文作者为了实用发明的。就是先把图像“模糊化”(粗粒化,Coarse-graining),去掉微观的随机噪声,然后算这个模糊图像的压缩大小(也就是它的 K(x) 近似值)。

- 通俗理解: 你眯着眼睛看世界。

- 看完全混合的咖啡(噪音):眯眼看就是一片灰,文件很小 →复杂度低。

- 看漩涡咖啡:眯眼看还是能看到漩涡,文件很大 → 复杂度高

-

所罗门诺夫的MAP估计——精致度

- 所罗门诺夫归纳法 (Solomonoff Induction) 告诉我们:对于任何数据,最可能的解释是那个最短的程序。这其实就是奥卡姆剃刀的数学版。

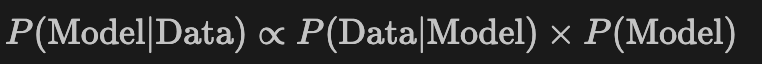

- 当我们把一个对象 x 拆解成 模型 (Model, S) 和 数据 (Data given Model, x|S) 时,我们其实是在做贝叶斯推断:

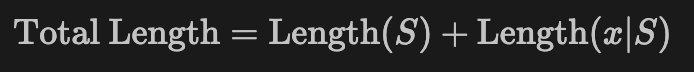

- 在信息论里,概率和长度是对数关系(L = -\log P)。所以最大化后验概率(MAP),等价于最小化总长度:

-

- Length(S): 描述规律的长度。这对应先验概率(越简单的规律越可能)。

- Length(x|S): 在规律 S 下描述具体数据的长度。这对应似然度(规律对数据的拟合程度)。

-

“精致度”做了什么?

- 它在寻找那个让“总长度”接近最小的方案中,专门把 Length(S) 这一项拎出来 12。

- 如果S太简单(比如“这是一堆随机数”),虽然 Length(S) 很小,但 Length(x|S) 会巨大(没解释任何东西),总长度不是最优。

- 如果 S 太复杂(比如“这就是这个数据本身”),虽然 Length(x|S) 是0,但 Length(S) 巨大(过拟合),总长度也不是最优。

- 只有找到那个最佳的平衡点——即那个包含了所有非随机结构,但又不包含任何随机噪声的模型 S——这时候的 S 就是所谓的 结构(Structure)。

- 所以说,精致度就是在做所罗门诺夫归纳时的最佳模型选择(MAP Estimation),它衡量的是在这个最佳解释中,“规律”到底占了多少分量,剔除了“偶然”的成分。

-

-

-

数学抽象的有效性

-

数学的深度

- 数学的深度并不是直觉思考所能比拟的。毕竟,我们的直觉似乎只能进行迅速的计算。因此,直觉推理并没有什么逻辑深度

-

一些逻辑深度很大而所罗门诺夫精致度很小的现象?

-

计算不可约性 (Computational Irreducibility),或者用更通俗的话说,这就是 “简单的规则,漫长的演化”。

- 所罗门诺夫精致度很小(Low Sophistication): 意味着这个对象的“生成规则”非常简单。 也就是描述“它背后的物理定律”的那段代码非常短。你可以把它写在一张便利贴上,甚至印在T恤上。

- 逻辑深度很大(High Logical Depth): 意味着从这个简单的规则出发,要得到现在的这个状态,计算机需要运行非常非常久的时间。 没有任何“捷径”可以直接跳到结果,你必须一步一步地模拟整个演化过程。

-

-

数学的简洁性

- 这本书中都是冗余的内容,它的所罗门诺夫精致度相对来说很低

- 数学语言不存在好几种可能的解释,而且无须花时间仔细思考这一语言中每个符号的意义

- 用计算机科学的术语来说,阅读这一语言只需要所罗门诺夫复杂度很小的算法,即使算法所需的计算时间可能很长。

- 这与那些非形式化的理论形成了鲜明对比,后者强烈依赖于对语言和其他人类“常识”的某种解释

- 非形式化理论的问题其实不是它们不精确,而是它们需要所罗门诺夫复杂度极大的算法(比如我们的大脑)才能拥有预测能力。

- 自然选择更偏爱那些能够预测环境和原始部落社会关系的语言和认知过程。

- 因此,数学的优雅似乎必将使数学家仔细探索并理解那些简洁的算法,也就是在所罗门诺夫的模型下拥有相当大的先验置信度的算法

-

数学的模块性

- 定理组成了预测性理论的基石,就像基础算法组成了所有复杂源代码的基石那样

- 数学语言让我们可以研究大量不同的模型——不必每次都重新发明轮子。

- 实践中的大量问题都可以写成在不同约束条件下对某个目标函数的最小化问题。这个框架就是最优化问题

- 拉格朗日量的量子化

- 诺特定理:对称 → 守恒

- 寻找不变性(Invariance)

- 在物理里: 我们不需要去解每一个复杂的微积分方程。只要我看一眼这个系统:“嘿,这东西转一圈看起来没变!” 我立刻就知道:“哈!那它的角动量一定守恒!” 我不需要算,我就知道答案。这是物理学家的**“作弊码”**。

- 在深度学习里: 还记得 CNN(卷积神经网络) 吗?它为什么要用“卷积”?因为它假设猫出现在图片的左上角和右下角是一样的。这就是利用了平移对称性!

- Transformer: 它为什么要用自注意力机制?因为它假设单词之间的关系不应该受它们距离多远的影响(某种程度上的长程关联对称)。

- 动量守恒 (Momentum) 来自 空间平移对称:

- 因为物理定律在空间的任何地方都一样(平移对称),所以动量必须守恒。

- 能量守恒 (Energy) 来自 时间平移对称:

- 因为物理定律昨天、今天、明天都一样(时间平移对称),所以能量必须守恒。

- “守恒定律”不是上帝随便规定的规则,而是“对称性”的必然结果

- 寻找不变性(Invariance)

-

-

-

C19 贝叶斯大脑 (先使用、再理解)

- 贝叶斯大脑

- 自然选择与贝叶斯

- 归纳的本质

- 作为计算器的大脑

- 理解的悖论

- 感知与错觉 ((贝叶斯推断))

- 地图

- 视错觉

- 运动感知

- 如何学习/获取知识

- 贝叶斯抽样

- 归纳问题

- 学习如何学习

- 抽象的恩赐

- 婴儿都是天才

- 语言

- 学习计数

- 心智理论

- 先天还是后天?

- 贝叶斯大脑

- 引入: